Új hozzászólás Aktív témák

-

Aprósólyom

addikt

Jajj a passmark....

Az emberek dolgoznak, játszanak a gépen, nem szintetikus teszteket futtatnak... A cinebench-nek több értelme van, de azok a benchmark tesztek is csak adott célközönségnek szólnak, aki Cinema 4D CGI munkából keresi a kenyerét. A passmark futtatásnak mi értelme van?

Az emberek dolgoznak, játszanak a gépen, nem szintetikus teszteket futtatnak... A cinebench-nek több értelme van, de azok a benchmark tesztek is csak adott célközönségnek szólnak, aki Cinema 4D CGI munkából keresi a kenyerét. A passmark futtatásnak mi értelme van?Jevons paradox

-

catalano

tag

Hmm... 10100F/10100 és 10400F/10400 szerintem simán viszi a kategóriáját.

AMD Ryzen 3 3100 lenne legalul, ha lehetne kapni. Ha van is, akkor 40 alatt nincs.

Intel/AMD a neve, pont nem érdekel.

Kicsi fiam gépébe még 3100-at sikerült vennem 35-ért (Ryzen 3600 volt a cél...).A 3600X ott volt már az asztalomon. Fel se bontottam, eladtam (nem vagyok nepper).

Nekem már "csak" 10100 jutott 31-ért akciósan. De visszagondolva már nem vettem volna meg az AMD-s konfigot, mert a lap is drágább (mind a kettő TOMAHAWK), meg a memória is.

És hát a 10100 jobb, mint a 3100. Igaz kicsivel (10%) és még olcsóbb is. Ennyi.

Értem én a viccet, csak nem szeretem...

-

Sinesol

veterán

Fenet se erdeklik a benchmark pontszamok, nem arra vesz az ember gepet, hogy benchmarkot futtasson. Alig lehet egyebkent valamit levonni a benchmark pontszamokbol, szal amugysem ernek semmit..

tomcat78: uj platformokra gondoltam, ma azert egy 2700-ba mar nem fektetnék.

[ Szerkesztve ]

-

arabus

addikt

Ha már ennyire bizonygatod magad.

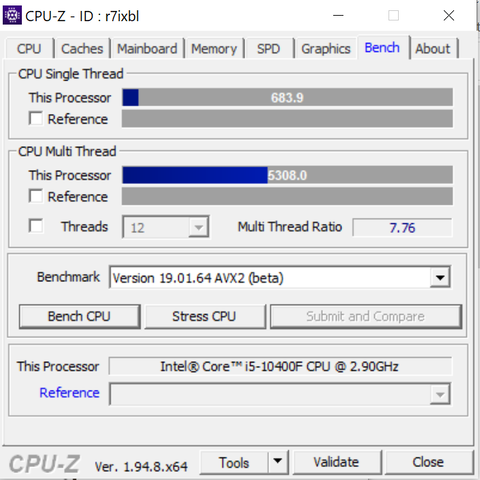

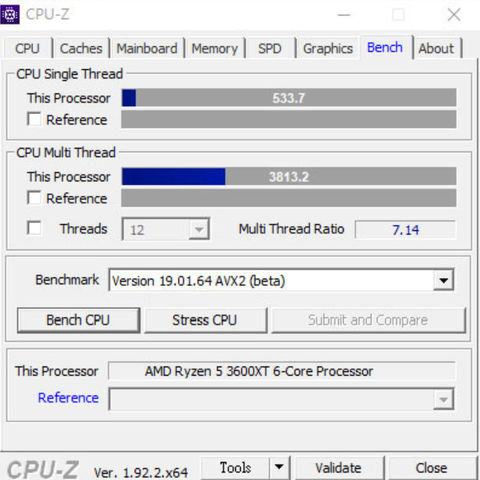

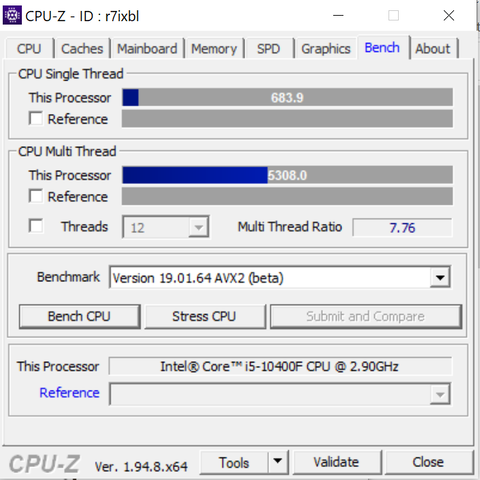

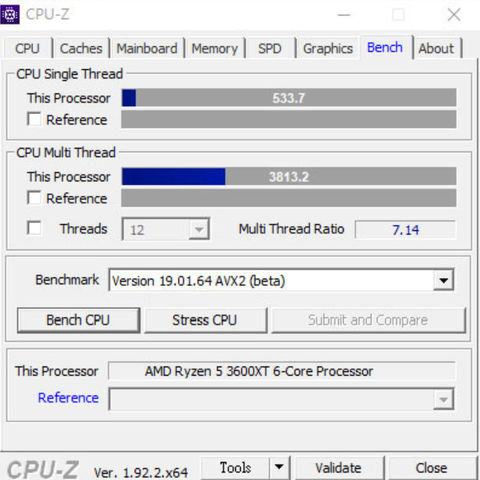

100ezres 3600xt vs 50ezres 10400f AVX2 pontszámokat nézd csak meg.

AVX2-ben amit már nagyon sok játék ill. program használ melyik is másfélszer?

Vedd le a szemüveget és nézd meg mi mennyiért mit ér!

Xeon Platinum 8468,Ryzen 7500F,Gigabyte B650M K,Xeon Phi,i9 7960X,i9 7920X,Xeon w2135,Gskill royal 4400,Gskill Trident Z,Pico 4,Red Devil 7900XTX,Asrock W790 WS,Fury Pro RDIMM 6000,Z590,Intel Cryo,Intel 11900F,Ryzen 5600,Radeon 7600,Radeon 6800...

-

Aprósólyom

addikt

Miért bonyolítod? Abban a programban kell tesztelni, amit a user használni fog: legyen az beépített benchmark vagy real-time használat közbeni mérés. Minden program más jellegű számításokat futtat, más utasításkészletet használ, az egyik jobban optimalizált több szálra, a másik kevésbé, az egyik jobban izzasztja a cache-t, a másik a rendszer memóriát, stb+stb...

Szintetikus benchmarkok arra kvázi arra jók, hogy 1-1 architechtúrán belül különböző procik relatív teljesítményszintjét össze tudd mérni. Ha már más architechtúra a két összevetendő proci, akkor már nagyon viszonylagossá válik az összehasonlítás ....Jevons paradox

-

Tigerclaw

nagyúr

De erre tudna reagalni az AMD is. 1-2 OEM -nek ajanlhatna kizarolagossagot vagy csinalhatna az amit az Intel epp most is csinal, vagyis referencia notebookokat is keszitethetne ODM-ekkel, bergyartokkal. A piacot nem erdekelne, hogy csak egy helyen tud AMD-s notit venni, ha az kompromisszummentes.

Ha szerencsenk van, talan most tavasszal a Microsoft folyatja a Surface Laptop szeriat AMD-vel, jo esetben Van Gogh, rosszabb esetben Lucienne alapon, ami osszel kimaradt. Persze lehetne Cezanne is, foleg hogy az utobbi ketto szamozasban elegge ossze lett mosva de abba a szegmensbe inkabb jobb IGP kellene, mint eros CPU/

Az a baj a világgal, hogy a hülyék mindenben holtbiztosak, az okosak meg tele vannak kételyekkel.

-

Tigerclaw

nagyúr

Rajtuk mulik. A TSMC annyi gyarta huz fel, amennyi kell a megrendelonek... persze csak ugy ha vallalja is a megrendelo hogy x evig y db chipet veluk gyartat. Az AMD is kaphatna nagyobb kapacitast, de lathatoan konzervativ modon allnak hozza a novekedeshez, ami talan mar tavaly is visszautott. Persze lehet hogy a COVID nekik is keresztbe tett rendesen.

Iden, sot talan jovore is csokkennek majd a megrendelesek globalisan, legalabbis amig helyre nem all a gazdasag es ujra le nem csokken a munkanelkuliseg.

Az a baj a világgal, hogy a hülyék mindenben holtbiztosak, az okosak meg tele vannak kételyekkel.

-

paprobert

senior tag

"másrészt 3-3.5 ghz körül optimális a processzorok energiahatékonysága"

Ez mindig egy mozgó célpont. Nem univerzális.

Pl.Mobilban csak az elmúlt 10 évben az optimális órajel 800-ról 2GHz-re kúszott fel. Szerverben ugyanez 1.2 GHz-ről 3GHz környékére.

Node, architektúra és power envelope válogatja hogy mi az optimális.Ebből indirekten következik, hogy ha az optimum pont magasan van, akkor elengedett TDP mellett lesz magas órajel is.

Az Intelt az elmúlt 3 évben az mentette meg, hogy az optimum pont már a Sandy-Ivy Bridge környékén is magasan volt, és csak a TDP-t kellett elszabadítaniuk a turbóval.[ Szerkesztve ]

640 KB mindenre elég. - Steve Jobs

-

Tigerclaw

nagyúr

Ha az OEM-ek tulsagosan az Intel iranyitasa alatt vannak, akkor egyszeruen inditaniuk kellett volna egy sajat termekcsaladot. Sok ceg sikerrel megoldotta ezt az AMD-hez kepest toredeknyi tudassal es tapasztalattal az eszkozgyartast tekintve. A fobb alkatreszek hazon belul vannak, referenciadesign-ert sem kell a szomszedba menniuk. Nem kell azonnal nagy termekpalettaban gondolkodni, eleg indulni pl. csak egy notebookal. Keszitsenek pl. egy "ultrabookot" sajat maguk, mert jellemzoen az amit szandekosan elcsesznek a bergyartok a rossz koritessel. Esetleg komolyabban mukodjenek egyutt a Microsofttal, hogy ok komromisszummentes laptopot keszitsenek. Sot veluk akar kothetnenek exclusive szerzodest is. Amig nem tudnak kello mennyiseget szallitani, csokkenthetnek a partner OEM-ek listajat es csak annak adnanak el, akinel beleszolhatnak abba is, hogy milyen koritest kapjon az a notebook. Az Intel is ezt csinalta/csinalja az ultrabook, athene, evo notik eseten. Megszabta hogy csak az epithet olyan gepeket, akik vallaljak, hogy a specifikacionak van egy minimalis szintje.

Az a baj a világgal, hogy a hülyék mindenben holtbiztosak, az okosak meg tele vannak kételyekkel.

-

Trollbjorn

csendes újonc

Az IPC-t már nem nagyon fogják tudni növelni, persze minden évben növelhető pár százalékkal ahogy a compilerek minősége is csak pár százalékot segített az elmúlt évtizedekben, csak ugye az ezzel nyert IPC javulás messze elmarad a korábbi évtizedekben megszokott órajel növekedéstől. Ahol ennél többet értek el IPC vagy szoftvereknél compilerek esetében az az újonnan bevezetett architektúrák és szoftver technológiák, mivel ezek alapvetően sokkal több helyen optimalizálhatók hiszen a kezdeti verzión mindig sokkal több fogást találsz mint mondjuk a 10-ediken. Prociknál az intel már a 10ik generációnál tart és igazi IPC előrelépés főleg a sandy bridge (2xxx számok) és környékén volt, ugyanez Ryzen esetén látható hogy a mostani 3ik generáció képes volt komoly IPC növekedésre (itt is főleg játékokban, más esetben már nem 2 számjegyű) de ez minden évben egyre kissebb lesz. Ugyanez pl. C/C++ fordítók esetén a több évtizedes fejlődés után már minimális de a mostani webes technológiák esetén mint a javascript még mindig jelentős hiszen egy viszonylag új technológia és sok lehetőség van az optimalizálásra. Egy architektúrát meg egy évtizedig is szoktak használni és gyakran vakvágánynak bizonyul, lásd pentium4 vagy bulldozer. Nem lehet a szekvenciális utasításvégrehajtást már nagyon sehova fejleszteni, legalábbis én nem találkoztam semmilyen alapkutatással ami arról írna hogy valami alapvetően új módszert tudnának. Amiket meg most használnak már tényleg egyre veszteségesebb optimalizációk, azaz egyre több fölösleges energiát esznek meg hogy cserébe az 1 szálas végrehajtás átlagos sebessége növekedjen. Legjobb példa a spekulatív végrehajtás ahol pl. az elágazás mindkét ágát kezded végrehajtani és később amikör rájösz hogy az egyik nem kell akkor eldobod az erdményét, ekkor nemcsak 2szeresen terheled a procit hanem a teljes memória alrendszert, és mint kiderült pár éve súlyos biztonsági réseket is csinálsz ezzel. Mindezt a "hack" szintű megoldást azért rakja be a hardver gyártó mert a szoftveres szinten nem tudtak vagy akartak párhuzamosítani pedig azon a szinten párhuzamosítva sokkal jobb eredemény érhető el, azaz egy butább hardver és okosabb szoftver jobb lehet, ahol a hardver 1 szálas teljesítménye rosszabb lesz viszont cserébe sokkal több szálú végrehajtás lesz aminek az összege nagyobb perf/watt-ot ad. Szerintem a biztonsági hibák tömege mutatja hogy bizony egyfajta zsákutcába érkezett ez a tendencia hogy IPC-t akarnak növelni mindenáron és ezért a jövőben nem ez lesz a fő céljuk.

Én szilicium alapú chip gyártásnál nem számítanék 1 szálas általános teljesítmény komolyabb növekedésére. Ezzel ellentétben az Apple M1 által bizonyított hogy milyen területeken lesz fejlődés továbbra is:

1, hardveres gyorsítás, ez mindig nagyságrendekkel jobb mint általános utasításkészleteken futtatott szoftveres út.

2, integráció, pl. minek folyamatosan másolni a CPU és GPU memóriája között az adatot, stb.

3, szoftveres párhuzamos feldolgozás, azaz ha van 16 magos procim akkor használja is már ki az játék

Az AMD azért üzemel kissebb frekvencián a top gamer prociknál is mert nem tud feljebb menni, egyszerűen 7nm-es cuccban a szivárgási áram és a felületegységre eső hőtermelés túl nagy lenne, először hibázni kezd az adott CPU aztán meg...

Az 5nm-es mobil proci is nagyon szépen megy 2-3Ghz-en de nyilván javítani kell még a gyártáson hogy a legyártott procik nagyobb része tudja a gamer gép esetén szükséges 3-4Ghz környékét, és ekkor is már szuperlineárisan nő a fogyasztás azaz már rég elromlott ott a performance/watt mutatód de nem érdekel téged mert az 5Ghz-es 14nm intellel versenyzel ami 200wattokat fogyaszt

Az intel nagy baja hogy adatközpontban és mobilban is a perf/watt számít, az 1 szálas teljesítmény már csak a gamer szubkultúrát érdekli meg pár olyan szerencsétlen embert akik valami legacy szoftverrel kűzdenek ami még 1 szálon fut csak és nem lehet leváltani

Szóval én az előző hozzászólásomban főleg gamer szempontból írtam intelre hogy semmi gondjuk nincs, de nyilván nagy náluk a pánik ha az utóbbi évben már kétszer váltottak vezért

-

Trollbjorn

csendes újonc

válasz

Pingüino

#107

üzenetére

Pingüino

#107

üzenetére

Lehet hogy félreérthetően írtam le, nyilván az általad említett frekvenciákat bírják 7nm-es ryzenek, azonban eddig az volt a tendencia hogy kissebb csíkszélesség egyik legnagyobb előnye az elérhető magasabb frekvencia, jelenleg az intel 5.3Ghz 1magos és akár 5Ghz all-core bír, a ryzen pár száz Mhz-el kevesebbet, és több helyen is leírták ennek okait amiket említettem is. Tehát itt mintha megfordult volna a tendencia, a 7nm-es gyártásnál egy évtizede tippeltünk volna 6Ghz max-ot amennyiben 14nm-en 5Ghz megy. És nem úgy tűnik az okok magyarázatából (max. teljesítménysűrűség, szivárgási áram) hogy ezen lehet segíteni majd a 3nm és további lépésekben. Ráadásul egyre drágább kifejleszteni az új gyártást, azt írják hogy minden egyes váltásnál 25%-al nőtt a költség az elmúlt kb. 20 évben, ez azt jelenti egyre kevésbé mernek majd váltani 3nm, 2nm, és tovább mivel egyre nagyobb pénzt kell befektetni és a fizikai korlátok miatt egyre nagyobb lesz a kockázat. Nyilván az intel is megoldhatatlan problémákba ütközött a 10nm-es megoldásuknál amin nagyon sokat buktak, és ez bármikor megtörténhet a többi gyártóval is. Zárójelben megjegyezve már lassan csak 2-3 gyártó van ami bizony már lehetővé teszi a kartellezést tehát direkt megegyeznek hogy lassítják a gyártás fejlesztését ha már külső versenyzőt nem látnak aki beugrana helyettük. Az se gond ha egy kínai ugrana be mert csak kitiltják a piacról egy kis USA/EU politikai lobbizással

Na jó az utóbbi már kicsit demagóg feltételezés talán

Na jó az utóbbi már kicsit demagóg feltételezés talán

Párhuzamosítást meg azért írtam mert láthatóan ott van a legtöbb lehetőség a fejlődésre, a klasszikus számítógépes megoldások túlnyomó többsége szekvenciálisan gondolkozik, márpedig a természetben azt látjuk hogy a legtöbb megoldás nagyon durván párhuzamos. Pl. elég sok kutatást lehet végezni a jelenleg alkalmazott szekvenciális algoritmusok lecserélésére. Meg ugye ez eddig egy ördögi kör is volt: mivel a szoftver nagy szekvenciális sebességből profitál ezért a hardvert arra fejlesztik jobban, a szoftveresek látván hogy minden évben gyorsabb a hardver hagyják az 1 szálas megoldásokat és inkább másba fektetik a pénzt, hiszen az 1 szálas programok helyességének a garantálása sokkal egyszerűbb feladat. Én már találkoztam olyan algoritmussal ami több szálon futott és bizony tartalmazott egy súlyos hibát ami csak akkor jött ki amikor egy bizonyos módon ütemezte az OS a végrehajtási szálakat amik csak abban a speciális esetben haltak le. És ez a hiba nem jött elő évekig, a tesztek se mutatták ki, és természetesen a jelenleg gyakorlatban alkalmazott szoftverek egyikénél sem biztosítható annak formális bizonyítása hogy helyesen működik a szoftvered, csak tesztelni tudod és remélni hogy ez a szúrópróbaszerű futtatgatás garantálja a minőséget. Ezen a téren van jelenleg a legtöbb előrelépési lehetőség szoftveres téren, és a hardver is támogatni fogja ezt ha látják hogy megéri. A konzoloknál már az előző generáció is 8 magos volt, a mostani meg 16 szálas, a motiváció biztos meglesz a párhuzamosításra

De ahogy már több szoftveres cikkben is említették ennek a kényelmes korszaknak ahol csak várni kell az 1 szálas teljesítmény növekedésére vége

Új hozzászólás Aktív témák

ph Közzétette az Intel a 2020-as év üzleti eredményei, az ehhez kapcsolódó bejelentések között a régi-új vezérigazgató a termékekről is ejtett pár szót.

Az emberek dolgoznak, játszanak a gépen, nem szintetikus teszteket futtatnak... A cinebench-nek több értelme van, de azok a benchmark tesztek is csak adott célközönségnek szólnak, aki Cinema 4D CGI munkából keresi a kenyerét. A passmark futtatásnak mi értelme van?

Az emberek dolgoznak, játszanak a gépen, nem szintetikus teszteket futtatnak... A cinebench-nek több értelme van, de azok a benchmark tesztek is csak adott célközönségnek szólnak, aki Cinema 4D CGI munkából keresi a kenyerét. A passmark futtatásnak mi értelme van?

Na jó az utóbbi már kicsit demagóg feltételezés talán

Na jó az utóbbi már kicsit demagóg feltételezés talán